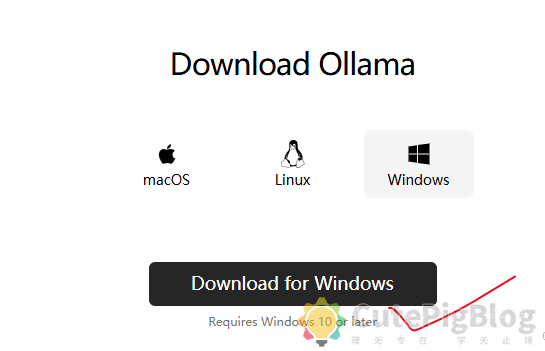

1.登录Ollama官网,点击下载安装包

亲测需要科学上网才能开始下载。

得到下面的安装包。

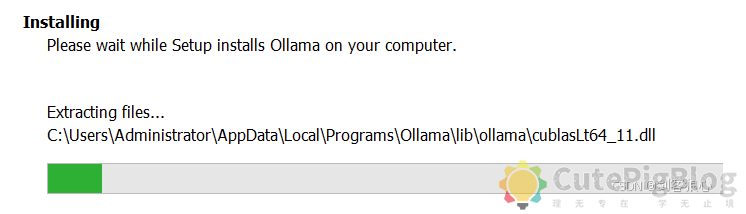

安装包下载完毕之后,点击,再点击install,会出现下面这样的安装进程,默认C盘且无法更改安装地址 。

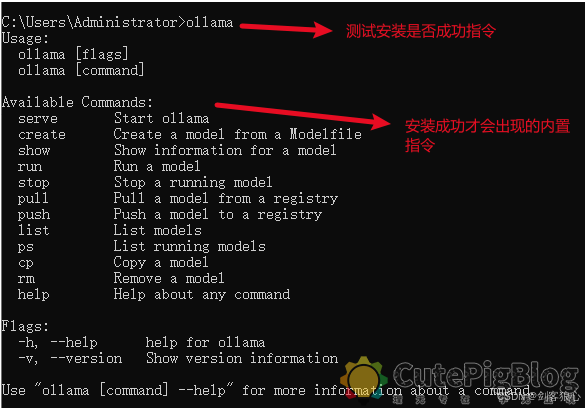

安装之后,电脑右下角会出现图标,如果不放心可以在CMD窗口输入ollama查看是否安装成功。

此时键入ollama list还是没有出现任何东西的。

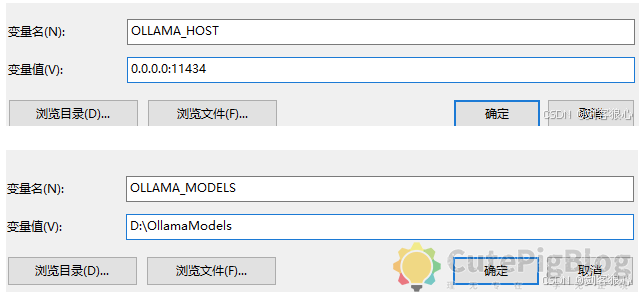

2.接下来需要配置环境变量:

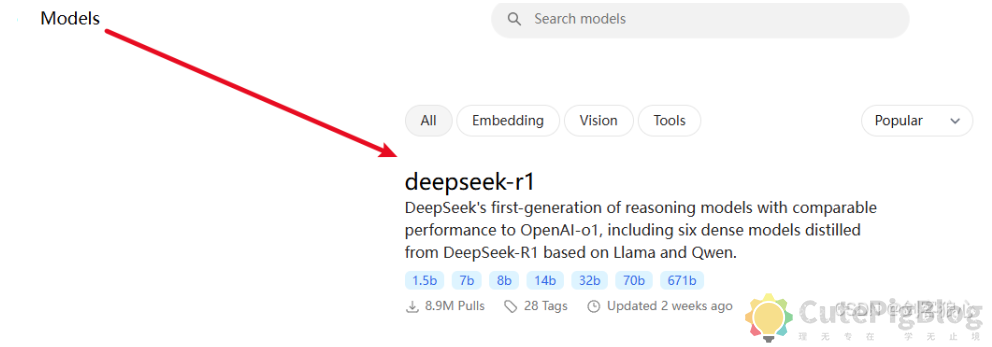

3.回到Ollama官网,点击Models,选择deepseek-r1模型

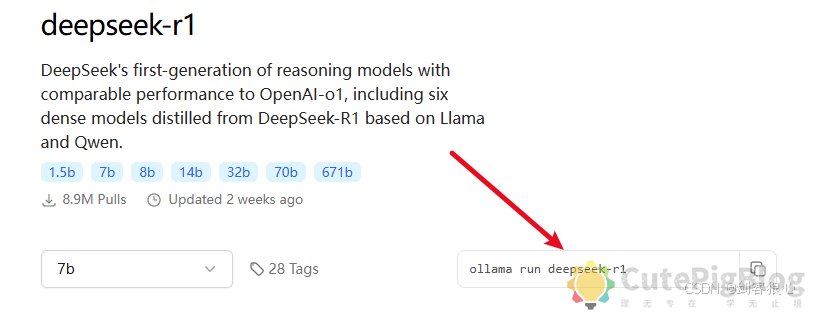

复制下面的指令,并粘贴在CMD窗口

此时黑窗口就会开始下载r1模型

![]()

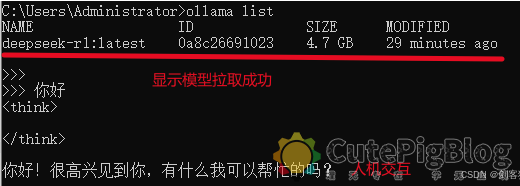

显示success之后,再键入ollama list就会有如下显示:

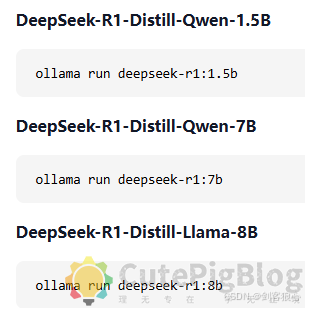

我这里更推荐下载下面带版本号的蒸馏模型,方便后续搭建知识库的时候引用

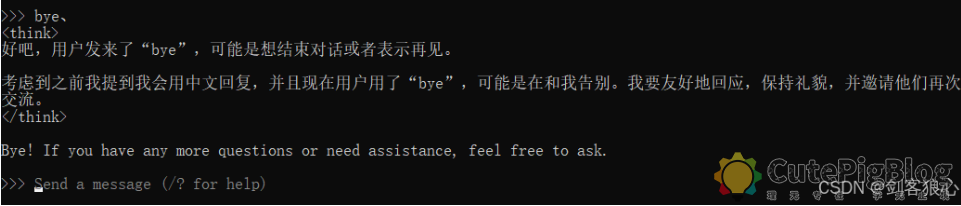

初体验:deepseek-r1给我的初感觉像是个刚学会说话的孩子,和chatgpt最大的使用区别就在于会把思考的过程也事无巨细呈现出来,两段式的回复使其更具拟人的色彩。

4.安装和搭建知识库软件

4.1安装Docker

在Docker官网下载安装包

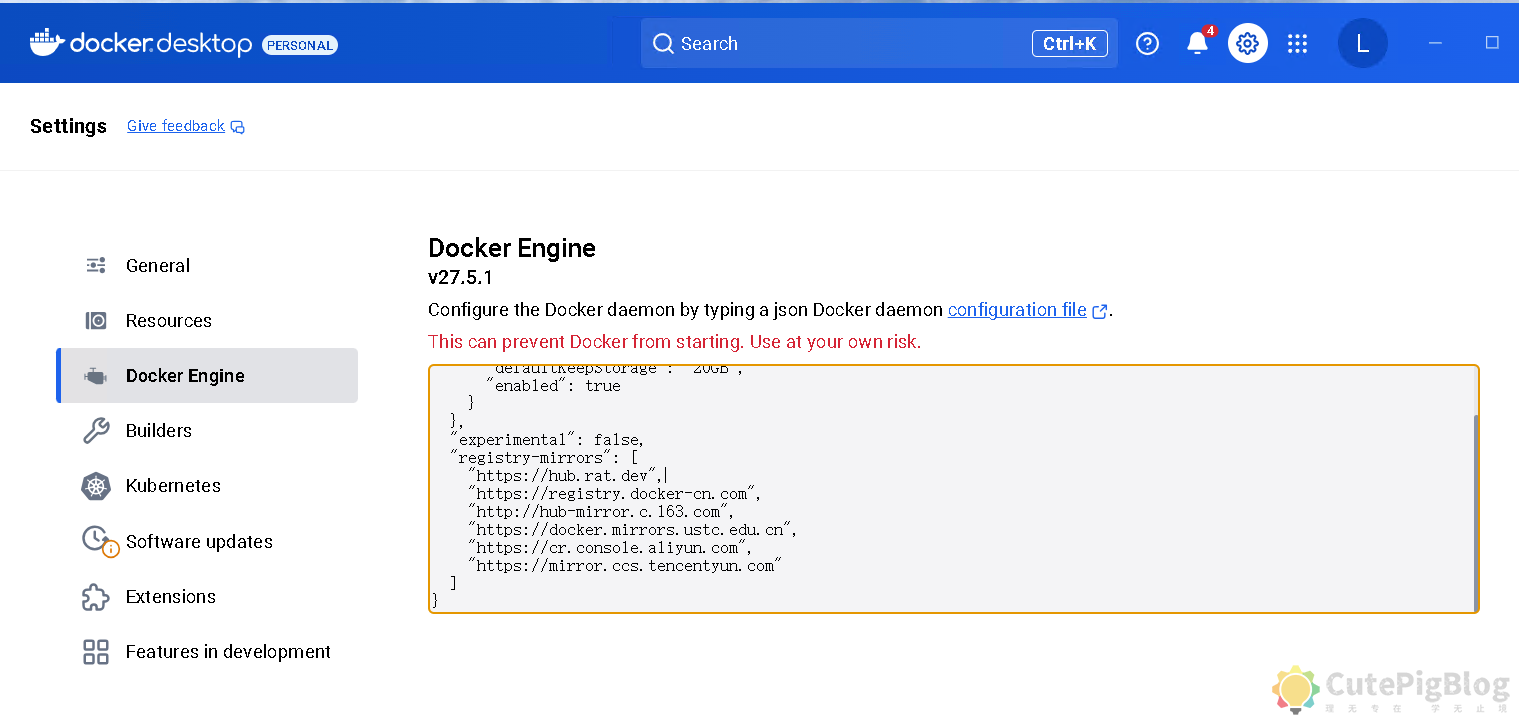

记得添加国内镜像

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 |

{ "builder": { "gc": { "defaultKeepStorage": "20GB", "enabled": true } }, "experimental": false, "registry-mirrors":[ "https://hub.rat.dev", "https://registry.docker-cn.com", "http://hub-mirror.c.163.com", "https://docker.mirrors.ustc.edu.cn", "https://cr.console.aliyun.com", "https://mirror.ccs.tencentyun.com" ] } |

下载完成docker之后保持docker桌面软件的打开状态。

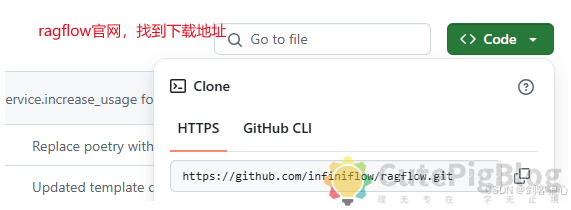

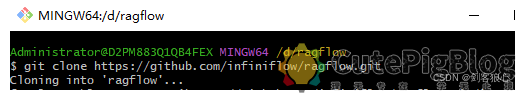

4.2 下载ragflow

随便找到一个空文件(如 D:\ragflow),打开文件夹然后右键打开git Bash并使用下面的代码,进行git克隆(前提是已经下载并安装好git Bash)

|

1 |

git clone https://github.com/infiniflow/ragflow.git |

注意:Git拉取代码前,可能需要先配置Git代理

|

1 2 |

git config --global http.proxy http://127.0.0.1:7890 git config --global https.proxy http://127.0.0.1:7890 |

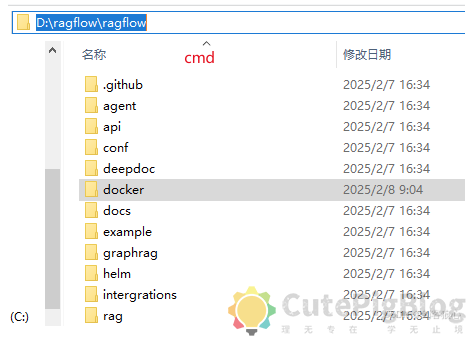

此时会得到下面的项目文件

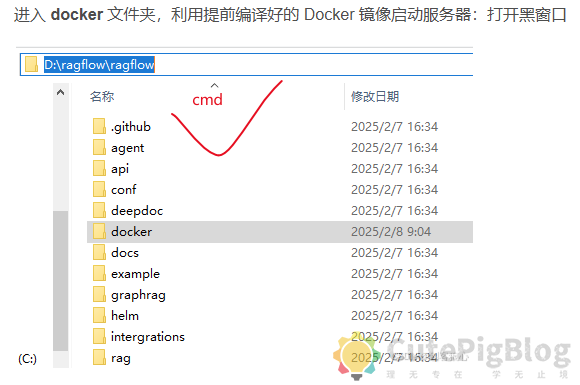

进入 docker 文件夹,利用提前编译好的 Docker 镜像启动服务器:打开黑窗口

Docker拉取镜像

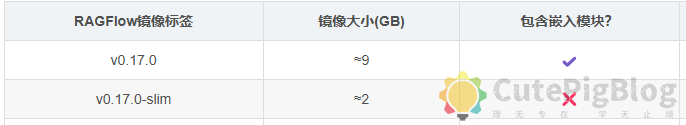

修改镜像为国内镜像并且选择embedding版本

如果下载是全量的RAGFlow镜像,会带有嵌入模型,可以按图中选择;另外也可以添加自定的嵌入模型,方法同前面的模型提供商设置

修改文件docker/.env/

默认配置为:RAGFLOW_IMAGE=infiniflow/ragflow:v0.17.0-slim

修改为国内镜像(全量镜像):RAGFLOW_IMAGE=registry.cn-hangzhou.aliyuncs.com/infiniflow/ragflow:v0.17.0

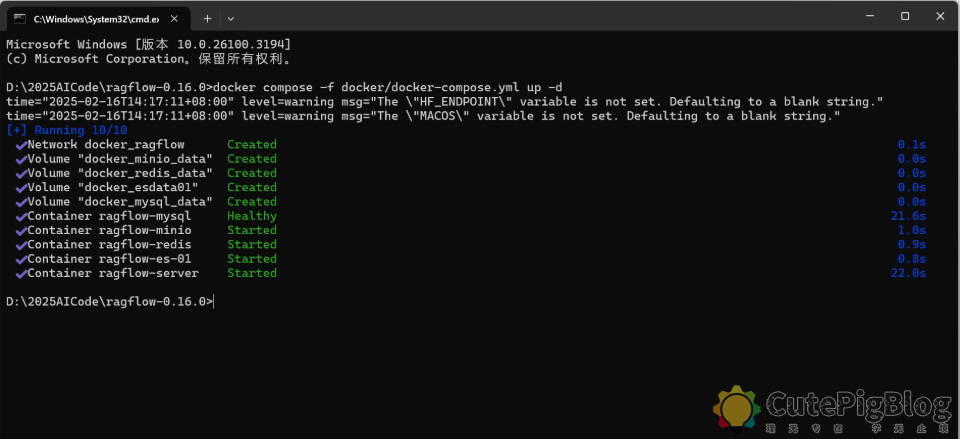

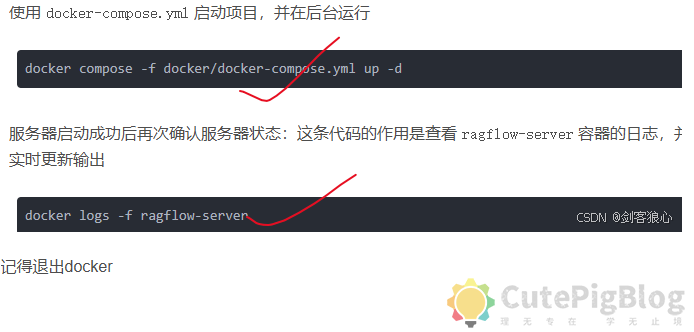

使用 docker-compose.yml 启动项目,并在后台运行

|

1 |

docker compose -f docker/docker-compose.yml up -d |

注意:首次执行docker compose时可能时间会很长,因为要拉取部署ragflow所依赖的docker镜像,所以耗时比较长

容器启动后的容器实例

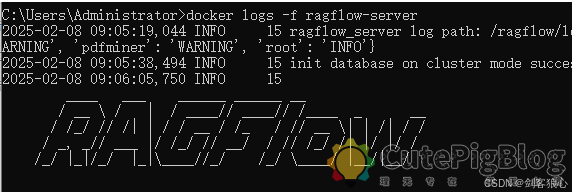

服务器启动成功后再次确认服务器状态:这条代码的作用是查看 ragflow-server 容器的日志,并实时更新输出

|

1 |

docker logs -f ragflow-server |

出现下面的图标,代表服务器启动成功

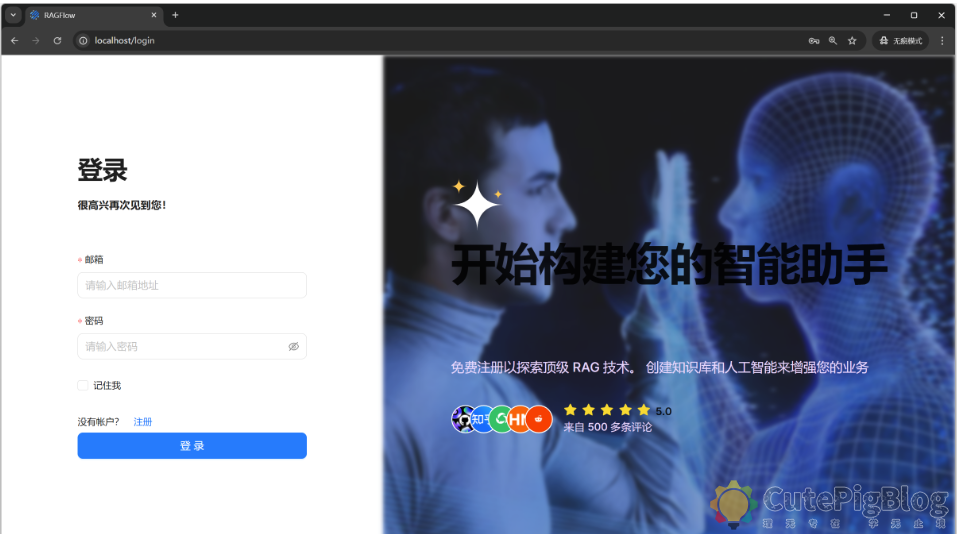

RAGFlow部署后默认的端口为80,打开浏览器输入地址: http://localhost

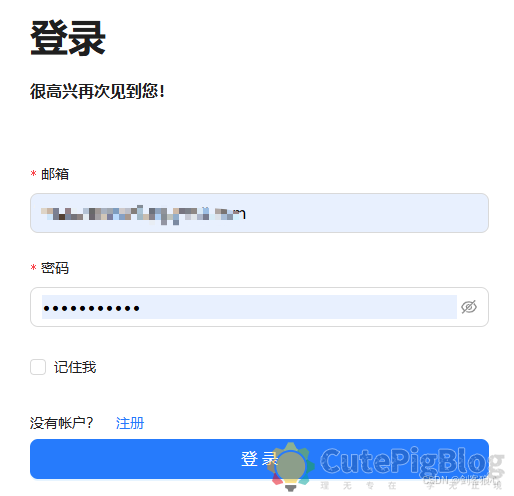

注册一个账号并登录。

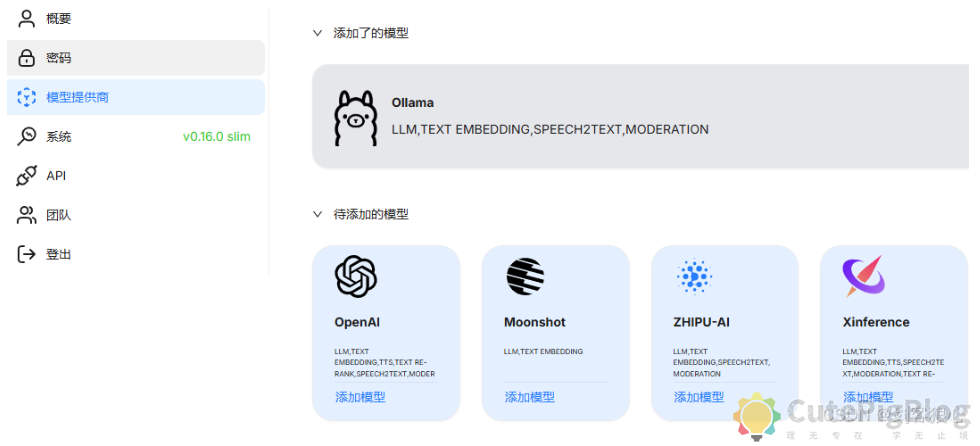

4.3配置模型

在rag界面点击右上角的头像,左侧找到模型提供商

在待添加中选择Ollama或者deepseek,我这里选择的是ollama,根据自己下载的模型名称,添加LLM

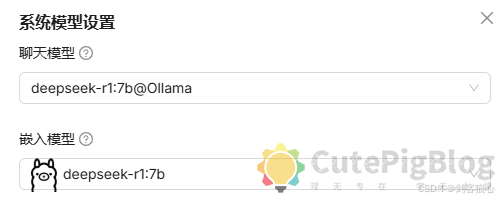

点击右上角系统模型设置完成模型设置。

4.4 搭建知识库

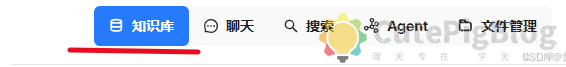

回到主界面,点击知识库并创建

这里的解析方法,需要根据自己的使用场景,自己选定,比如general方法支持的文件格式为DOCX、EXCEL、PPT、IMAGE、PDF、TXT、MD、JSON、EML、HTML。此方法将简单的方法应用于块文件:

- 系统将使用视觉检测模型将连续文本分割成多个片段。

- 接下来,这些连续的片段被合并成Token数不超过“Token数”的块。

搭建完知识库之后,再次点击进去,准备添加知识库文件,例如,我现在创建一个txt文本,自定义了一个概念,模拟企业级别的概念应用。

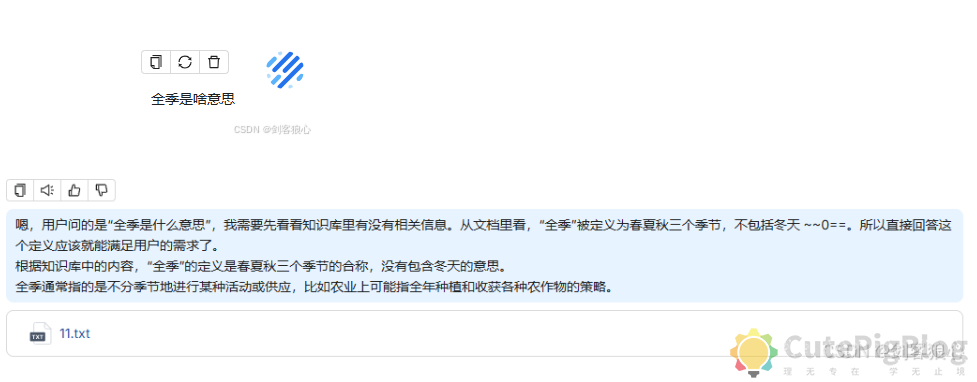

4.5测试

点击:聊天->新建助理,设置自己的聊天机器人

有了聊天助理之后,点击新建聊天。

如下,当我问及某概念的时候,它就会从数据库中提取相关信息,用deepseek-r1模型进行回答

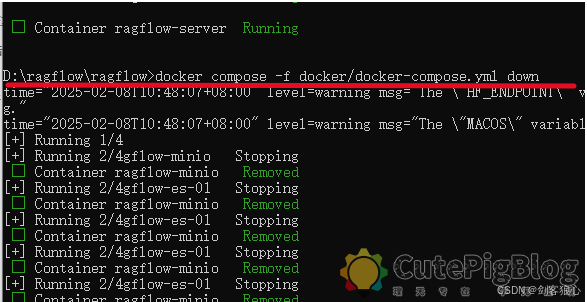

4.6 关闭服务器

关闭ragflow服务器

|

1 |

docker compose -f docker/docker-compose.yml down |

像下面这样,它会关闭 docker-compose.yml 里所有的容器,但不会删除数据卷和网络

4.7重启服务器

重复上面的3个步骤

浏览量: 61